Estabilização de Vídeo com OpenCV: Um Pipeline Completo, do Zero ao Resultado Visual

Como eliminar tremores de câmera e suavizar vídeos com técnicas simples, baseadas em transformações afins e suavização por média móvel

Introdução

Gravar um vídeo com estabilidade perfeita é um desafio. Mesmo com os avanços em gimbals, estabilizadores ópticos e sensores embarcados, tremores involuntários continuam sendo um problema frequente — especialmente em filmagens feitas com câmeras manuais, drones, celulares ou webcams de baixo custo. O resultado são vídeos com jitter, tremores visuais que prejudicam não apenas a experiência do espectador, mas também comprometem algoritmos de Visão Computacional, como tracking, optical flow, OCR, SLAM e reconhecimento de gestos.

A boa notícia é que não é necessário utilizar redes neurais profundas, bibliotecas pesadas ou ferramentas comerciais para resolver isso. Com um pouco de geometria, álgebra linear e Python puro, é possível construir um pipeline completo de estabilização de vídeo — do zero, com controle total sobre cada etapa, altamente explicável e com resultados surpreendentemente eficazes.

Neste artigo, vamos desconstruir e implementar um estabilizador de vídeo frame-a-frame, utilizando Python. A técnica é baseada em:

Detecção de movimento entre quadros com ORB (um detector rápido e robusto),

Suavização da trajetória com média móvel,

Aplicação de transformações afins corrigidas para compensar os desvios da câmera.

E o melhor: ao final do artigo, você terá um estabilizador funcional com saída visual comparando vídeo original x vídeo estabilizado, além de visualizações intermediárias de matching entre quadros e gráficos de trajetória.

O Problema: Por que estabilizar vídeos?

Todo vídeo é, por definição, uma sequência de quadros no tempo. E embora a maioria das pessoas associe a estabilidade visual à estética ou ao conforto de quem assiste, a estabilização de vídeo vai muito além de uma mera questão visual — ela é um requisito técnico fundamental para diversos pipelines de Visão Computacional, Processamento de Imagens e Machine Learning.

Impacto do jitter em vídeos reais

O termo jitter refere-se a variações não intencionais na posição da câmera entre quadros consecutivos. Isso pode ocorrer por vários motivos: trepidações manuais, vibrações mecânicas, ausência de estabilização óptica, uso de dispositivos portáteis ou filmagens em movimento. Mesmo variações de poucos pixels por quadro são suficientes para produzir um efeito indesejado de “pulsação” na imagem — que além de desconfortável para o espectador, também interfere drasticamente em análises automáticas.

Imagine, por exemplo, um drone filmando uma plantação para análise NDVI, ou uma câmera embarcada em um carro autônomo detectando faixas de pista. Se a posição do horizonte oscila desnecessariamente, os algoritmos de segmentação e detecção se tornam inconsistentes — e modelos que dependem de estabilidade espacial e continuidade temporal falham em cascata.

Implicações em algoritmos de Visão Computacional

A estabilização é pré-requisito silencioso (mas crítico) em muitos pipelines. Entre os principais impactados, destacam-se:

SLAM (Simultaneous Localization and Mapping): pequenos deslocamentos falsos da câmera geram mapas inconsistentes e localização imprecisa.

Object Tracking: a falta de estabilidade introduz ruído no movimento aparente dos objetos, confundindo o tracker e provocando drift.

Optical Flow: assume movimento suave e contínuo; jitter gera gradientes inconsistentes que afetam a qualidade dos vetores.

OCR / Detecção de Texto em Vídeo: trepidações desfocam ou distorcem caracteres entre quadros, reduzindo drasticamente a acurácia.

Modelos de ML baseados em sequência: redes LSTM, GRU e transformers temporais sofrem com ruído espacial não-modelado.

Em vídeos médicos (ex: endoscopias, laparoscopias) ou industriais (ex: inspeções visuais automatizadas), a estabilidade do vídeo é crítica para evitar falsos positivos, alarmes indevidos ou perda de diagnósticos.

Como funciona a estabilização?

O processo de estabilização segue uma arquitetura lógica e modular, adotada inclusive em pipelines comerciais e industriais, mas aqui simplificada com foco educacional. A ideia central é rastrear como a câmera se move ao longo do tempo e aplicar correções para suavizar esse movimento — quadro a quadro.

O pipeline pode ser dividido em seis etapas principais:

Ingestão e leitura do vídeo

Abrimos o vídeo, extraímos metadados (como número de quadros, resolução, FPS) e preparamos a estrutura para leitura e gravação dos frames.Detecção de movimento entre quadros

Utilizamos detectores como ORB para encontrar pontos de interesse (ex: cantos), e fazemos matching entre quadros consecutivos. Com esses matches, estimamos a transformação afim entre eles — representando translação e rotação da câmera.Cálculo da trajetória da câmera

As transformações estimadas (dx, dy, da) são acumuladas ao longo do tempo, resultando em uma trajetória bruta da câmera. Essa trajetória descreve, em termos de geometria, como a câmera "andou" ao longo do vídeo.Suavização da trajetória

Aplicamos uma média móvel sobre a trajetória para remover oscilações abruptas e jitter de alta frequência. Isso gera uma nova curva suavizada, mais próxima de um movimento natural e estável.Aplicação da transformação corrigida (warping)

A diferença entre a trajetória original e a suavizada gera um vetor de correção. Construímos novas transformações que "voltam" a imagem para essa trajetória suavizada, aplicando warp comcv2.warpAffine().Renderização do resultado final

Após corrigir cada frame, recombinamos todos eles em um novo vídeo. Podemos ainda aplicar um zoom leve para remover bordas pretas e compor uma visualização comparativa com o vídeo original e a versão estabilizada.

Essa sequência — da análise do movimento à reconstrução do vídeo — oferece um pipeline altamente interpretável e modular, ideal para aprendizado, experimentação e integração com soluções maiores.

Desafios da estabilização "na mão"

Embora ferramentas comerciais (como Adobe Premiere, DaVinci Resolve ou o estabilizador automático do YouTube) ofereçam soluções eficientes, elas são caixas-pretas. Para engenheiros, pesquisadores e educadores, isso representa um obstáculo: não é possível entender o que foi feito, adaptar o pipeline para domínios específicos, nem otimizar o desempenho para aplicações embarcadas ou em tempo real.

Implementar uma solução “na mão”, com código explicável, permite:

Controlar cada passo da cadeia (detecção, suavização, warp)

Simular, debugar e ajustar parâmetros finamente

Explorar abordagens híbridas, clássicas ou de aprendizado profundo

Integrar com pipelines maiores (ex: IA médica, drones autônomos, análise de vídeo em edge)

A estabilização, portanto, não é um luxo visual — é uma etapa de pré-processamento estrutural que garante a consistência do vídeo como dado. E ao construirmos esse pipeline do zero, dominamos não apenas uma técnica, mas os fundamentos geométricos e estatísticos que sustentam toda uma classe de aplicações em visão computacional.

Mãos à Obra: Implementando o Estabilizador em Python

Abaixo está o código completo do nosso pipeline de estabilização — limpo, explicável e pronto para rodar.

Este script cobre todo o ciclo de vida da estabilização:

Estima os movimentos quadro a quadro usando ORB + Brute Force

Acumula e suaviza a trajetória da câmera com média móvel

Aplica transformações corrigidas por

cv2.warpAffine()Faz zoom adaptativo leve para remover bordas pretas

Gera uma saída comparativa com vídeo original + estabilizado + visualização de matches

A seguir, vamos dissecar o código completo do estabilizador de vídeo que construímos, explicando cada bloco funcional do pipeline. A proposta é que você compreenda a lógica geométrica, estatística e computacional por trás de cada linha.

Explicando o Código por Partes

Inicialização: Leitura do vídeo e configuração do ambiente

A classe VideoStabilizer começa com a leitura do vídeo de entrada, extração de seus metadados (número de quadros, FPS, dimensões) e inicialização dos módulos de escrita e detecção de movimento. Utilizamos o detector ORB pela sua robustez e velocidade, junto ao matcher Brute Force com métrica Hamming.

class VideoStabilizer:

def __init__(self, input_path, output_path="output_stabilized.mp4", output_size=(640, 480)):

self.input_path = input_path

self.output_path = output_path

self.output_size = output_size

self.transforms = []

self.match_frames = []

self.cap = cv2.VideoCapture(self.input_path)

self.n_frames = int(self.cap.get(cv2.CAP_PROP_FRAME_COUNT))

self.w = int(self.cap.get(cv2.CAP_PROP_FRAME_WIDTH))

self.h = int(self.cap.get(cv2.CAP_PROP_FRAME_HEIGHT))

self.fps = self.cap.get(cv2.CAP_PROP_FPS)

fourcc = cv2.VideoWriter_fourcc(*'mp4v')

self.out = cv2.VideoWriter(self.output_path, fourcc, self.fps, self.output_size)

self.orb = cv2.ORB_create(1000)

self.bf = cv2.BFMatcher(cv2.NORM_HAMMING, crossCheck=True)Suavização com média móvel

Para suavizar a trajetória da câmera, utilizamos uma média móvel clássica. Essa técnica reduz o jitter, eliminando flutuações de alta frequência no movimento.

def moving_average(self, curve, radius=5):

window_size = 2 * radius + 1

kernel = np.ones(window_size) / window_size

padded = np.pad(curve, (radius, radius), mode='edge')

smoothed = np.convolve(padded, kernel, mode='same')

return smoothed[radius:-radius]

A função smooth_trajectory aplica essa média móvel separadamente a cada componente da trajetória (translação X, Y e rotação):

def smooth_trajectory(self, trajectory):

smoothed = np.copy(trajectory)

for i in range(trajectory.shape[1]):

smoothed[:, i] = self.moving_average(trajectory[:, i])

return smoothed

Compensando bordas pretas com zoom adaptativo

Após aplicar uma transformação geométrica ao quadro, é comum surgirem bordas pretas. Para contornar isso, aplicamos um leve zoom de 4% usando uma matriz de escala centrada:

def fix_border(self, frame):

s = frame.shape

T = cv2.getRotationMatrix2D((s[1]//2, s[0]//2), 0, 1.04)

return cv2.warpAffine(frame, T, (s[1], s[0]))

Estimando o movimento entre quadros

Aqui está o coração do pipeline. A função estimate_transforms detecta keypoints com ORB, calcula descritores, executa o matching e estima a transformação afim entre cada par de quadros consecutivos.

def estimate_transforms(self):

_, prev = self.cap.read()

prev_gray = cv2.cvtColor(prev, cv2.COLOR_BGR2GRAY)

for i in range(1, self.n_frames):

success, curr = self.cap.read()

if not success:

break

curr_gray = cv2.cvtColor(curr, cv2.COLOR_BGR2GRAY)

kp1, des1 = self.orb.detectAndCompute(prev_gray, None)

kp2, des2 = self.orb.detectAndCompute(curr_gray, None)

if des1 is None or des2 is None:

self.transforms.append([0, 0, 0])

self.match_frames.append(prev)

continue

matches = self.bf.match(des1, des2)

matches = sorted(matches, key=lambda x: x.distance)

if len(matches) < 10:

self.transforms.append([0, 0, 0])

self.match_frames.append(prev)

continue

pts1 = np.float32([kp1[m.queryIdx].pt for m in matches]).reshape(-1, 1, 2)

pts2 = np.float32([kp2[m.trainIdx].pt for m in matches]).reshape(-1, 1, 2)

m, _ = cv2.estimateAffinePartial2D(pts1, pts2)

if m is None:

self.transforms.append([0, 0, 0])

self.match_frames.append(prev)

continue

dx = m[0, 2]

dy = m[1, 2]

da = np.arctan2(m[1, 0], m[0, 0])

self.transforms.append([dx, dy, da])

self.match_frames.append(self.draw_matches(prev, kp1, curr, kp2, matches))

prev_gray = curr_gray

prev = curr.copy()

Aplicando a correção e renderizando os quadros estabilizados

A função stabilize é responsável por executar o pipeline completo: estimar os movimentos, suavizar a trajetória, aplicar as transformações corrigidas e gerar o vídeo de saída.

def stabilize(self):

self.estimate_transforms()

trajectory = np.cumsum(self.transforms, axis=0)

smoothed = self.smooth_trajectory(trajectory)

diff = smoothed - trajectory

new_transforms = np.array(self.transforms) + diff

self.cap.set(cv2.CAP_PROP_POS_FRAMES, 0)

for i in range(self.n_frames - 1):

success, frame = self.cap.read()

if not success:

break

dx, dy, da = new_transforms[i]

m = np.array([

[np.cos(da), -np.sin(da), dx],

[np.sin(da), np.cos(da), dy]

])

stabilized = cv2.warpAffine(frame, m, (self.w, self.h))

stabilized = self.fix_border(stabilized)

match_vis = self.match_frames[i]

match_resized = cv2.resize(match_vis, (640, 240))

orig_resized = cv2.resize(frame, (320, 240))

stab_resized = cv2.resize(stabilized, (320, 240))

bottom = np.hstack((orig_resized, stab_resized))

full_frame = np.vstack((match_resized, bottom))

self.out.write(full_frame)

cv2.imshow("Match | Original + Estabilizado", full_frame)

if cv2.waitKey(10) == 27:

break

self.cap.release()

self.out.release()

cv2.destroyAllWindows()

Execução

Por fim, o script é executado com um comando simples que instancia a classe com o nome do vídeo e chama o método stabilize():

if __name__ == "__main__":

stabilizer = VideoStabilizer("video.mp4")

stabilizer.stabilize()

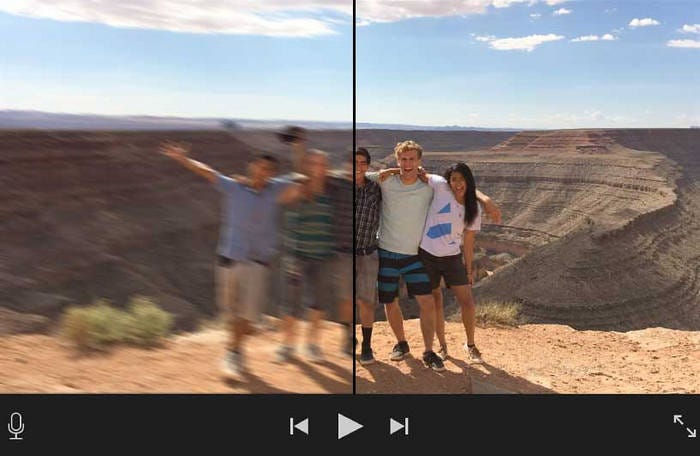

Como resultado de processamento temos o video abaixo onde é possível visualizar todas as etapas do nosso código. Canto superior esquerdo: o vídeo original com os keypoints detectados e suas correspondências entre quadros consecutivos, evidenciando como o ORB e o Brute Force Matcher encontram estruturas visuais estáveis na cena (como o caminhão e as árvores).

Canto superior direito: provavelmente o segundo quadro da sequência, também com matches, reforçando a consistência do rastreamento visual ao longo do tempo.

Canto inferior esquerdo: o vídeo original — com instabilidade evidente, como jitter horizontal e microvariações na linha do horizonte.

Canto inferior direito: o vídeo estabilizado — com o mesmo conteúdo, mas suavizado, com a câmera virtual seguindo uma trajetória mais estável e coerente, eliminando variações abruptas.

Essa visualização resume com perfeição o que nosso pipeline realiza:

Detecta e rastreia características visuais da cena usando ORB.

Calcula o movimento real da câmera, estimando a trajetória original com base nas transformações entre quadros.

Suaviza a trajetória com média móvel, removendo jitter de alta frequência.

Aplica correções geométricas via

cv2.warpAffine, estabilizando cada frame.Renderiza o resultado, comparando visualmente o original com o estabilizado.

O ganho visual é evidente: as árvores, a linha da estrada e o caminhão permanecem mais centrados e constantes na versão estabilizada, enquanto na original, esses elementos apresentam oscilações perceptíveis.

Conclusão

Com este projeto, vimos que estabilizar vídeos não precisa ser um mistério escondido atrás de ferramentas comerciais ou redes neurais pesadas. Com uma combinação de visão computacional clássica, algoritmos explicáveis e um bom domínio de transformações geométricas, conseguimos construir um pipeline robusto, visualmente eficaz e altamente educacional.

O vídeo de comparação final ilustra perfeitamente o impacto do nosso código: do caos ao controle, do jitter ao fluxo estável. O caminhão e as árvores tremem bem menos— eles deslizam suavemente como deveriam, mesmo sem hardware dedicado ou software proprietário.

Github: https://github.com/FelipeAmaral13/EstudosVisaoComp/tree/master/estabilizacao_video